Le droit d’auteur est un monument qui régit la création et la diffusion de la culture depuis déjà pas mal d’années. Il semble avoir été toujours là, mais comparé à la culture, il est encore tout jeune ; le droit d’auteur tel que nous le connaissons est une notion dont les bases se trouvent il y a environ deux siècles. À l’ère d’Internet et du libre partage, cette notion appartient à présent au passé, car l’équilibre entre l’auteur et le public a changé ; une ère s’achève pour le droit d’auteur, une autre arrive.

Le droit d’auteur aujourd’hui

Petite mise au point sur le droit d’auteur tel qu’il est construit de nos jours. Le droit d’auteur tel qu’on le connaît à présent trouve ses origines au XVIIIe siècle, ce qui est, comparé à la culture qui a plusieurs millénaires d’âge, très jeune. Avant cette période (même si des velléités apparaissent dès la Renaissance), il n’y avait pas de droit d’auteur du fait que les productions culturelles étaient souvent anonymes et que les procédés de copie que l’on connaît maintenant n’existaient pas, réduisant très fortement le risque de contrefaçon. Par ailleurs, la culture n’était pas considéré comme un bien marchand de la manière dont certains aimerait bien la voir de nos jours. La culture était avant tout une production artisanale et était le fruit du talent de leur auteur qui ne pouvait que très rarement être copié, ce qui n’impliquait pas de protections particulières.

L’apparition et la démocratisation de l’imprimerie commence à remettre en cause ce modèle plus ou moins idéal pour les auteurs, notamment dans le milieu littéraire. Ainsi, au cours des XVIIe et XVIIIe, des revendications apparaissent (la plupart émanent des philosophes des Lumières eux-mêmes) pour permettre une protection sur les œuvres littéraires. Considérant que les intérêts des auteurs et des éditeurs sont communs, l’Angleterre créé la notion de copyright au XVIIe siècle qui inspire ensuite les américains lorsqu’ils insèrent leur propre copyright dans leur constitution en 1787. Du côté français, c’est la Révolution française qui met en place des protections pour les œuvres dans les années 1791 – 1793, afin de remplacer les privilèges abolis en 1789. Au fil des deux siècles suivants, le droit d’auteur se construit, notamment autour de la Convention de Berne, pour donner celui que nous connaissons d’aujourd’hui.

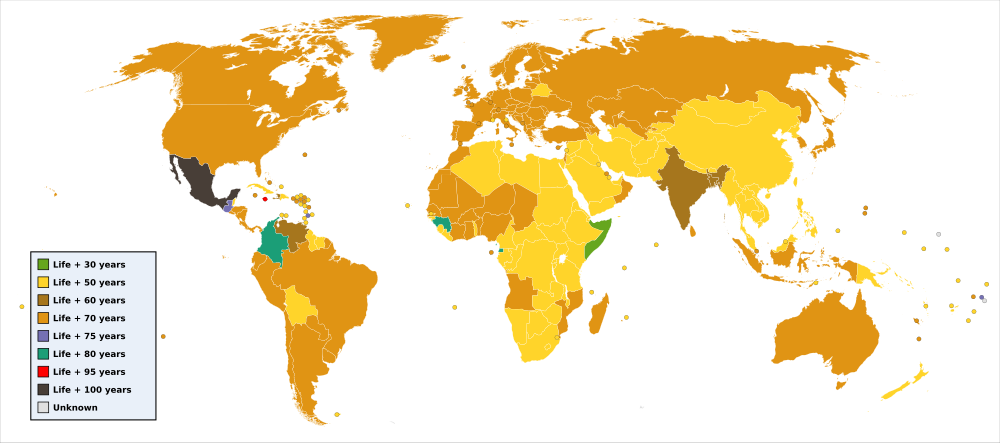

La grande aberration du droit d’auteur élargi au descendant : une impossibilité d’accès libre à une œuvre pendant au moins un siècle (Psychoslave, licence Art libre).

Qu’est-ce que le droit d’auteur ? Ce sont des prérogatives exclusives qui sont accordées à l’auteur. Il est divisé entre le droit moral (inaliénable), qui permet de reconnaître la paternité de l’auteur sur son œuvre et vise le respect de l’intégrité de l’œuvre, et le droit patrimonial qui lui confère un monopole sur l’exploitation de son œuvre ; ce dernier est souvent cédé par contrat à ceux qui produisent l’auteur et exploitent et promotionnent son œuvre. Il est assez amusant de voir que l’auteur a tellement de prérogatives sur ses œuvres qu’il est plus ou moins un monarque absolu (ce qui est le comble pour une création des Lumières) sur ses créations, décidant de leur destiné comme bon lui semble, sans qu’il n’ait de comptes à rendre. La législation actuelle est tellement rigide et accorde tellement de prérogatives à l’auteur qu’en réalité, nous violons tous inconsciemment le droit d’auteur (voir le blog de Désert de sel en lien en fin d’essai). Par ailleurs, ce droit d’auteur empêche tellement de choses qu’il est en réalité une arme contre la diffusion de la culture qui reste aux mains des élites qui ont à la fois la culture et les droits d’auteurs et qui n’accordent que ce qu’ils souhaitent aux citoyens, qui en sont dépourvus, avec les conditions qu’ils choisissent eux-mêmes (et à leur avantage). La grande absurdité est aussi la règle du maintien des droits sur les œuvres plusieurs décennies après la mort de l’auteur ; en effet, les héritiers touchent une rente quasiment à vie sur des productions qu’ils n’ont pas réalisés : ils vivent sur le talent (qu’ils n’ont pas souvent) de leurs parents et ce, sans faire le moindre effort. Par ailleurs, ils bloquent l’accès libre à des œuvres pour plusieurs décennies (voir graphique ci-dessus).

La culture libre

La culture qui a dominé les deux derniers siècles est ce que j’appellerai une culture fermée, refusant les échanges (sauf contrepartie) et où l’auteur et le public sont séparés par une barrière invisible. Par ailleurs, cette culture n’hésite pas à faire usage de répression violente envers ceux qui ne sont pas de son côté (les peines lourdes encourues en cas de violation des droits d’auteur et les procès). En parallèle de la culture fermée, s’est développée à partir des années 70-80 la culture libre, basée sur les principes de collaboration, de libre partage et d’échanges. Contrairement à la culture fermée, il s’agit d’une culture citoyenne, ouverte à tous dans des règles à la fois peu contraignantes, mais qui imposent le respect et la moralité des liens entre les acteurs. Les piliers de cette culture sont bien entendu les licences libres qui sont une complémentarité au droit d’auteur.

La licence GNU permet la transparence, le libre partage et la libre modification (Aurelio A. Heckert, GFDL 1.3)

Il existe aussi les licences de libre diffusion qui ont un peu plus de restrictions que les licences libres, mais accordent au public les droits fondamentaux qui lui manquent avec le droit d’auteur actuel, notamment le libre partage. Cependant, certaines (je pense notamment à la CC-BY-NC-ND) ne sont pas des licences qui représentent l’équilibre entre l’auteur et le public que doit être le droit d’auteur. Dans des cas plus libres, ces licences sont surtout une protection à l’encontre d’organisations qui sont bien tentées d’exploiter les œuvres sous licence libre comme elles l’entendent (même sans respecter la licence).

Licences libres et licences de libre diffusion sont l’aperçu des conditions du futur droit d’auteur.

Internet : nouvelle interaction entre les auteurs et le public

Les législations sont toutes d’accords sur ce point : le droit d’auteur est un équilibre entre les auteurs et le public. Cependant, le droit d’auteur actuel accorde tellement de privilèges à l’auteur et/ou aux autres ayant-droits que cet équilibre est rompu ; il y a actuellement un déséquilibre en faveur de ces derniers. Internet permet aujourd’hui un échange d’informations dans des proportions jusque-là jamais atteintes avec deux principes fondamentaux : la liberté et l’égalité. Que permet Internet vis-à-vis du droit d’auteur ? Tout simplement de remettre les pendules à l’heure. En effet, Internet permet des échanges et une implication plus directe des communautés de fans dans la conception des œuvres, ce qui influe fortement sur leur évolution. Du temps des comics-strip des années 70, l’évolution de l’histoire dépendait de l’inspiration de l’auteur, mais aussi des résultats économiques des œuvres ; si jamais une œuvre voyait ses ventes diminuer, le héros mourrait, mais pouvait ressusciter si jamais l’intérêt du public se faisait de nouveau sentir. Dans ces affaires, le public était une simple variable, mais n’était pas un acteur déterminant.

Le droit d’auteur est en déséquilibre, trop à l’avantage des auteurs et des ayants droit (Balfour Smith, Canuckguy & Badseed, CC-BY 3.0)

Avec Internet, les choses changent ; le public peut directement échanger à propos de l’œuvre et de son évolution. Il peut aussi être le défenseur des droits moraux de certains auteurs qui voient leurs œuvres remixées, mais peut aussi être le défenseur de l’essence originelle d’une œuvre qui dérive trop (voir le billet de Calimaq, lien en fin d’essai). Hier juste spectateur, le public devient acteur dans la création des œuvres. Dans les projets libres, cette tendance se remarque encore plus où le public est acteur et spectateur de l’œuvre, il échange d’égal à égal avec le ou les auteurs qui, eux, font de même ; l’un des exemples les plus probants de ce phénomène est celui des sagas MP3 où les auteurs peuvent compter sur une large communauté composite pour créer et améliorer leur œuvre, tout en faisant de même avec d’autres auteurs, et peuvent aussi compter sur une communauté de fans qui donnent des avis et participent de fait, à la conception de l’œuvre. D’autres exemples, comme des films financés par des dons de particulier, montrent que la place du public change dans la conception des œuvres et est en train de faire de lui un collaborateur de l’auteur, ce qui pourrait lui donner certains droits.

La résistance des conservateurs et des économistes

Tout changement dans une organisation entraîne une acquisition d’avantages pour une partie de la population au détriment d’une autre, c’est un équilibre humain. Ainsi, le nouveau droit d’auteur qui apparaît est bien entendu défavorable aux auteurs par rapport au précédent ; mais le précédent était défavorable au public, tandis que le nouveau lui sera. En réalité, le changement s’amorce d’un déséquilibre vers un équilibre, le trop-plein de privilèges accordés aux auteurs reviendront au public, tandis que ces derniers garderont leurs droits fondamentaux qui leur permettront de rester égal-à-égal avec le public. Malgré cela, il existe toujours une caste qui refusera la perte de ses privilèges et préférera partir en croisade et se poser en martyr plutôt que ne rien faire. Nous assistons ainsi à des attaques frontales de la part de conservateurs et de professionnels qui voient leur activité menacée par un processus logique et irréversible contre de nombreux aspect de ce processus. Pour cela, ils n’hésitent pas à mettre en avant les difficultés financières, la soi-disant illégalité de certaines productions ou actions ou encore leur soi-disant immoralité.

SOPA, PIPA, ACTA, Hadopi… autant de mesures pour tenter de freiner vainement un processus déjà en marche et irréversible (The Document Foundation d’après le code de Zachary Johnson, CC-BY-SA 3.0)

Une autre grande catégorie des gens partant en croisade contre ce processus sont les intérêts financiers de la culture fermée. Ces structures qui se font des millions sur le dos des auteurs et du public ne peuvent en effet penser qu’elles puissent perdre un jour leurs mines d’or. C’est dans cette logique que des projets de loi comme SOPA, PIPA ou ACTA, présentés comme des lois anti-piratage pour soi-disant protéger les auteurs qui périclitent forcement à cause du piratage massif. Il y a aussi derrière un appui fort de l’élite conservatrice qui ne veut pas perdre son monopole de contrôle sur la culture et n’hésite pas à se lancer dans du copyfraud (le fait de s’attribuer des droits sur une œuvre sur laquelle nous n’en possédons pas). Le but de ces manœuvres est de criminaliser encore plus des pratiques qui sont le fruit d’une mutation sociétale et de lancer une vaste campagne de répression pour conserver le contrôle sur la culture et tout ce que cela implique, avec au passage le début d’un contrôle de l’Internet.

Le futur droit d’auteur

Le futur droit d’auteur devra permettre un passage plus rapide vers le domaine public (Diti d’après Boris23, DP)

« La plus sacrée, la plus légitime, la plus inattaquable, et, si je puis parler ainsi, la plus personnelle de toutes les propriétés, est l’ouvrage fruit de la pensée d’un écrivain ; c’est une propriété d’un genre tout différent des autres propriétés. Lorsqu’un auteur fait imprimer un ouvrage ou représenter une pièce, il les livre au public, qui s’en empare quand ils sont bons, qui les lit, qui les apprend, qui les répète, qui s’en pénètre et qui en fait sa propriété. » – Le Chapelier, 1791 (Source : La Quadrature du Net)

Le droit d’auteur actuel ne lit que la première partie de la citation, le droit d’auteur qui arrive la prendra en compte dans son intégralité. La conception des œuvres ne pourra pas toujours être le fruit d’une personne seule qui s’appuiera sur une communauté de fans autour de lui qui l’aideront et qui auront de fait quelques droits sur l’œuvre finale. L’auteur verra ses droits moraux respectés et le public pourra réutiliser l’œuvre dans des conditions de partage et d’échanges, tout en respectant et en soutenant l’auteur dans ses créations. Enfin, le droit d’auteur ne sera pas au service d’intérêts financiers, impliquant la mise en demeure automatique dans le domaine public à partir de la mort de l’auteur, mais au service de l’auteur et du public. Au-delà de revenir à l’essence même du droit d’auteur, la culture deviendra ce qu’elle devait toujours être : la propriété de l’Humanité.

Aller plus loin

- Article Droit d’auteur de Wikipédia (partiellement utilisé pour cet essai)

- De la révolution culturelle du XXIe siècle, un essai sur la révolution culturelle enclenchée par Internet

- La réforme du droit d’auteur, ce qui doit (au moins) être réformé dans le droit d’auteur actuel

- Nous sommes tous des contrefacteurs, blog de Désert de sel démontrant l’abusrdité du droit d’auteur tel qu’il est construit aujourd’hui

- Les Mystérieuses Cités de Plomb (ou quand le public se fait défenseur du droit moral sur l’oeuvre), billet de Calimaq sur les nouveaux rapports de force entre les auteurs et le public et leurs conséquences sur l’évolution des œuvres

Cet essai de Juraastro est mis à disposition selon les termes de la licence Creative Commons Attribution – Partage dans les Mêmes Conditions 3.0 non transposé.